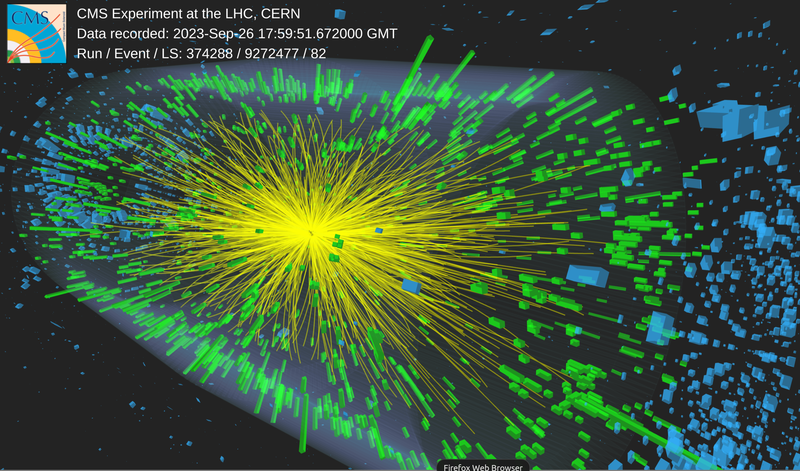

Durch energiereiche Zusammenstöße können zusammengesetzte Teilchen wie Protonen in ihre elementaren Bestandteile zerlegt werden. Wenn die Energie einer Kollision groß genug ist, kann sie auch zur Erzeugung von Materie in Form von neuen Elementarteilchen umgewandelt werden. Die direkten Reaktionsprodukte zerfallen jedoch in der Regel extrem schnell in leichtere Teilchen, die vom Entstehungsort wie Glassplitter bei einem Verkehrsunfall wegfliegen. Diese Bruchstücke gilt es in Teilchendetektoren nachzuweisen, um die ursprüngliche Reaktion zu rekonstruieren. In einem typischen Experimentaufbau der Teilchenphysik kommen daher viele verschiedenartige Detektortypen gleichzeitig zum Einsatz, mit denen die Zerfallsprodukte einer Teilchenreaktion nachgewiesen werden können. Daraus lassen sich komplexere physikalische Messgrößen ableiten, beispielsweise, in welche Teilchen genau die Ursprungsteilchen wie häufig und unter welchen Bedingungen zerfallen oder wie schwer die Teilchen sind.

Mit vielen Detektoren auf der Suche

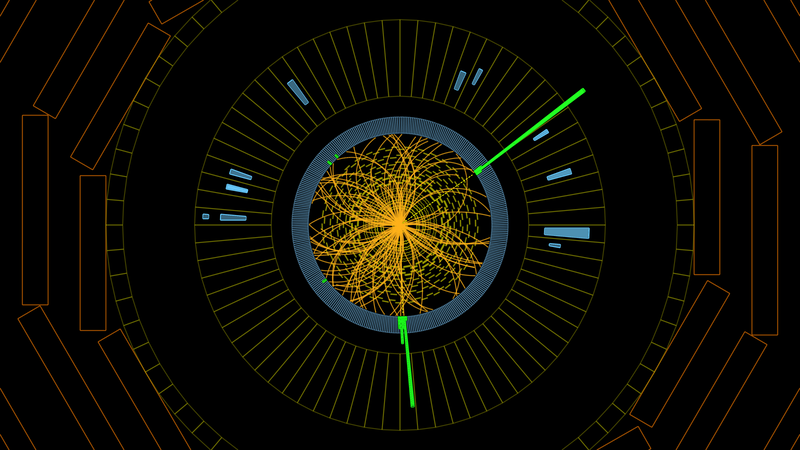

Die Bahnen von elektrisch geladenen Teilchen werden mit Spurdetektoren gemessen. Weil die Detektoren in ein Magnetfeld eingebettet sind, ergeben sich aus der Bahnkrümmung die elektrische Ladung und der Impuls dieser Teilchen. Durch Zurückverfolgen ihrer Bahnen kann ggf. ein gemeinsamer Ursprungsort (Vertex) festgestellt werden. Im Maßstab der Elementarteilchen eher langlebige Kollisionsprodukte wie das Bottom-Quark zerfallen beispielsweise erst nach wenigen Piko-(Billionstel-)Sekunden und können so über ihre Tochterteilchen direkt nachgewiesen werden. Die Geschwindigkeit von geladenen Teilchen kann über ihre Flugzeit zwischen zwei Detektorebenen, über den Energieverlust in Materie oder über die Emission von elektromagnetischer Strahlung (etwa als Tscherenkowstrahlung) gemessen werden. Photonen und Elektronen werden in elektromagnetischen Kalorimetern vollständig absorbiert, woraus sich ihre Energie bestimmen lässt. Die Energie von Hadronen – wie Protonen und Neutronen – hingegen wird in hadronischen Kalorimetern, äußerst massiven Anordnungen aus Absorber- und Detektormaterial, bestimmt. Energiereiche Myonen durchdringen selbst diese Detektoren und werden in dahinter liegenden Spurdetektoren nachgewiesen.

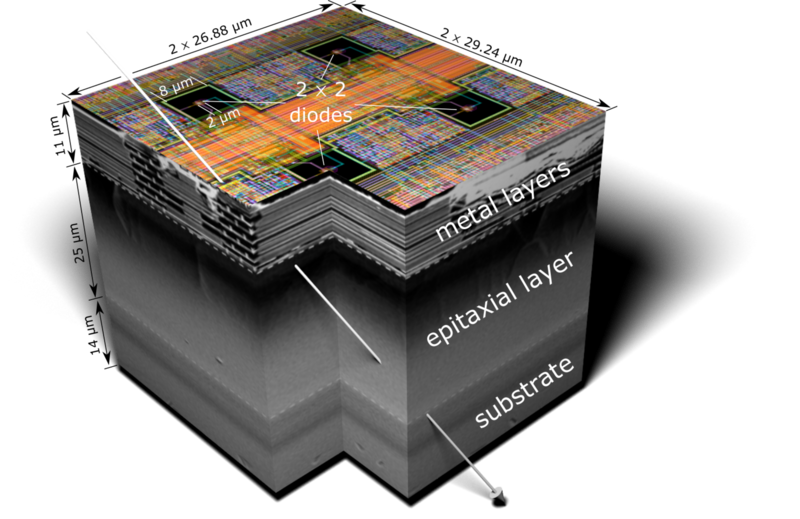

Als Detektormaterialien kommen Festkörper, Gase oder Flüssigkeiten zum Einsatz. Durch die Wechselwirkung der Teilchen mit dem Detektormaterial wird kurzfristig direkt oder indirekt (z. B. über die Emission von Licht) elektrische Ladung freigesetzt. Dies induziert elektrische Signale, aus denen durch hochintegrierte Verstärker- und Digitalisierungselektronik Informationen zu Zeit, Amplitude und – bei entsprechender Strukturierung des Detektionsvolumens – Ort der Detektion gewonnen werden. Komplexe Detektionssysteme setzen sich aus vielen einzelnen Komponenten zusammen, die häufig speziell für diese Anwendung entwickelt wurden. Bei der Integration dieser Komponenten muss die Infrastruktur zur Stromversorgung, Datenauslese und Kühlung auf möglichst leichten Trägerstrukturen mechanisch kompakt und stabil untergebracht werden.

Mikrometergenaue Präzisionsmessungen – wie solche zur Spur- und Vertexmessung – erfordern entsprechend kleine Detektorzellen und sehr dünne Detektoren über große Flächen. Dadurch wird eine unerwünschte Teilchenstreuung oder die Bildung von Sekundärteilchen minimiert. Monolithische aktive Pixeldetektoren integrieren die Sensorik und Elektronik in den gleichen, mit modernsten Halbleiterprozessen hergestellten Chips, in Pixel von nur wenigen zehn Mikrometern Kantenlänge. Diese Sensorchips lassen sich auf nur wenige zehn Mikrometer Dicke reduzieren und sind dadurch flexibel wie eine Folie.

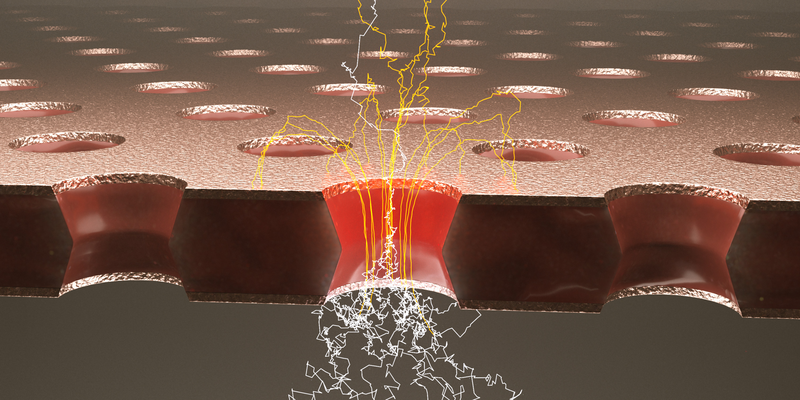

Auch gasgefüllte Detektoren nutzen die winzige elektrische Ladung, die beim Durchgang von ionisierender Strahlung erzeugt wird, zum Nachweis von Teilchen. Um ein elektronisch nachweisbares Signal zu erzeugen, wird das elektrische Signal durch Lawinenbildung von immer weiteren Elektronen in hohen elektrischen Feldern verstärkt. Gasgefüllte Detektoren können sehr große Volumina abdecken, ohne dass dafür viel Material benötigt würde. Fotolithografische Technologien erlauben es heutzutage, Verstärkungs- und Auslesestrukturen herzustellen, die nur wenige Mikrometer groß sind. Mit mikrostrukturierten Gasdetektoren lassen sich sehr hohe Teilchenraten hochgenau verarbeiten.

Der Large Hadron Collider (LHC)

ist der weltweit größte und leistungsfähigste Teilchenbeschleuniger. Er ist Teil des Europäischen Forschungszentrums CERN bei Genf und ging 2008 in Betrieb. In einem 27 Kilometer langen unterirdischen Ring erreichen Protonen fast Lichtgeschwindigkeit. An vier Kreuzungspunkten treffen die Protonenpakete in gegenläufigen Strahlen aufeinander. Dabei hat jedes Proton eine Energie von 7 TeV (Tera-Elektronenvolt); dies entspricht einer 7500-fachen Energie im Vergleich zur Protonmasse. In einem weiteren Betriebsmodus werden Pakete von Bleikernen auf hohe Energie (ca. 285 TeV) beschleunigt und aufeinandergeschossen. Die ebenfalls unterirdisch installierten Detektoren ALICE, ATLAS, CMS und LHCb registrieren die Teilchenreaktionen elektronisch und werten sie aus.

Um die (fast) lichtschnellen Protonen auf ihrer Kreisbahn zu halten, braucht es 1232 Ablenkmagnete. Dabei handelt es sich um supraleitende Elektromagnete, die bei einer Temperatur von 1,9 Kelvin (−271 °C) den elektrischen Strom widerstandslos leiten und somit sehr starke Magnetfelder von 8,36 Tesla erzeugen. Zum Vergleich: Das Erdmagnetfeld hat am Äquator eine Stärke von etwa 0,000 03 Tesla. Der Bau des LHC und der Experimente war nur durch viele innovative Technologien möglich, die mittlerweile auch außerhalb der Teilchenphysik Anwendung finden – unter anderem in der Medizin. Mehr als 10 000 Wissenschaftler:innen aus ungefähr 500 akademischen Instituten weltweit tragen zum LHC-Projekt bei.

Jeder Protonenstrahl besteht aus fast 3000 Paketen mit je 100 Milliarden Protonen. Die Teilchen sind allerdings so klein, dass es bei jedem Aufeinandertreffen der Pakete nur zu etwa 40 Kollisionen kommt. Da sich aber 40 Millionen Mal pro Sekunde Teilchenpakete treffen, ereignen sich im LHC mehr als eine Milliarde Kollisionen pro Sekunde! Die Analyse der dabei entstehenden riesigen Datenmengen geschieht mithilfe des LHC-Computing-Grids, einem weltweiten Computernetzwerk, in dem Zehntausende Rechner miteinander verbunden sind.

Gregor Herten

Die Entdeckung des Higgs-Bosons

Am 4. Juli 2012 verkündeten die ATLAS- und die CMS-Kollaborationen am LHC gemeinsam die Entdeckung eines neuen Teilchens mit den Eigenschaften des lange gesuchten Higgs-Bosons (siehe auch „Das Standardmodell der Teilchenphysik“ auf Seite 35). Die Suche nach diesem Teilchen war zuvor jahrzehntelang erfolglos geblieben. Erst der 2008 in Betrieb genommene LHC lieferte die erforderliche Energie und Intensität und die beiden Großexperimente ATLAS und CMS die nötige Messgenauigkeit, um dieses seltene Teilchen zu identifizieren.

Das Higgs-Teilchen taucht dabei nicht direkt in den Detektoren auf, sondern vielmehr seine Zerfallsprodukte. Die beiden Experimente konzentrierten sich auf zwei vorhergesagte Zerfälle des Higgs, die zwar äußerst selten sind (weniger als 1%), deren Zerfallsprodukte sich aber gut nachweisen lassen: Zum einen der Zerfall in zwei Photonen (H → γγ), zum anderen der Zerfall in zwei Leptonenpaare (H → ZZ → 4 Leptonen).

Die statistische Analyse zeigte, dass das Signal die Nachweisschwelle für eine Entdeckung überschreitet. Genauere Messungen in den folgenden Jahren bestätigten eindrucksvoll, dass das neue Teilchen einen Spin von 0 hat und genau die erwarteten Kopplungseigenschaften des Higgs-Bosons im SM besitzt.

Ein Jahr nach der Entdeckung des Higgs-Bosons am LHC erhielten François Englert und Peter Higgs den Nobelpreis für Physik für die „theoretische Entdeckung eines Mechanismus, der zu unserem Verständnis des Ursprungs der Masse subatomarer Teilchen beiträgt.“

Gregor Herten

Aufwendige Datenauswertung und lange Experimentierdauer

Moderne Verfahren zur Datenauslese und Datenverarbeitung ermöglichen Experimente mit extrem hohen Datenraten. Detektorsysteme etwa, die für die nächste Ausbaustufe des Large Hadron Colliders (LHC) entwickelt werden, sollen bis zu zehn Billionen (1013) Teilchenspuren pro Sekunde vermessen! Diese stammen aus Hunderten sich überlagernder Kollisionen. Klassische Verfahren lesen die Detektordaten dann vollständig aus, wenn ein schneller Prozessor ein Kollisionsereignis als „interessant“ erkennt (Trigger). Neuere Methoden wenden stattdessen Data Streaming an. Dabei senden die Detektoren kontinuierlich die Daten von Teilchentreffern an einen Computer-Cluster. Dies ist ein Hochleistungscomputersystem, das Teilchenspuren, Teilchenmassen, Zerfallstopologien und somit die zugrunde liegenden physikalischen Wechselwirkungsprozesse sehr schnell erfassen kann. Spezialisierte Rechner mit programmierbaren integrierten Schaltungen, Grafikkartensysteme, massiv parallel arbeitende Algorithmen sowie Methoden der künstlichen Intelligenz kommen dabei zum Einsatz.

Die Forschungsarbeiten erfolgen in Zusammenschlüssen von Gruppen an Universitäten und Forschungszentren mit internationaler Ausrichtung. Die Teilnehmenden planen, konstruieren und stellen Komponenten eines Experimentes bereit, das sie dann über Jahre hinweg an einem Beschleuniger betreiben. Die Entwicklung und der Bau der Detektoren erfordert Fachwissen, das in langjähriger Arbeit an speziell eingerichteten Detektorlaboren oder Werkstätten aufgebaut wird. Von der Konzeption des Forschungsziels bis zum Experimentierbetrieb können viele Jahre vergehen. Da es sich bei den untersuchten Prozessen um statistische quantenphysikalische Ereignisse handelt, dauern Messkampagnen in der Regel ebenfalls mehrere Jahre, denn erst mit genügend ähnlichen Daten aus vielen Teilchenkollissionen lässt sich mit sehr hoher Wahrscheinlichkeit sagen, ob es sich bei einer Messung mit neuem Inhalt tatsächlich um eine Entdeckung oder nur eine statistische Fluktuation handelt. Oft werden die Experimentieranlagen nach einer Anfangsphase erweitert oder modernisiert, wie der LHC, der zum Jahr 2028 zum High-Luminosity-LHC ausgebaut wird, da sich sowohl die technischen Möglichkeiten für Detektoren und Datenverarbeitung als auch der wissenschaftliche Kenntnisstand weiterentwickeln.

Experimente der Astroteilchenphysik nutzen prinzipiell ähnliche Technologien, aber in anderer Zusammensetzung. Ihre Signalquellen sind die natürliche Strahlung aus dem All – und die ist teils noch energiereicher als das, was mit Teilchenbeschleunigern machbar ist. Gammastrahlungsausbrüche und Supernovaexplosionen beschleunigen einzelne Teilchen auf Energien weit über dem, was irdische Beschleuniger erreichen können. Für den Nachweis hochenergetischer Strahlung werden auch die Erdatmosphäre, das Ozeanwasser oder das Eis in der Antarktis genutzt. Als Signal wird häufig durch die Teilchen erzeugtes Licht nachgewiesen, die Tscherenkowstrahlung. Für die Suche nach seltenen Ereignissen, wie z. B. den Nachweis von Neutrinos oder Dunkler Materie, kommen spezielle Aufbauten aus flüssigen Szintillatoren, hochreinem Wasser, verflüssigten Edelgasen oder hochempfindlichen Quantensensoren zum Einsatz. Sie sind häufig in tiefen Untergrundlaboratorien angesiedelt, um den Hintergrund aus kosmischer Strahlung und natürlicher Radioaktivität zu minimieren.